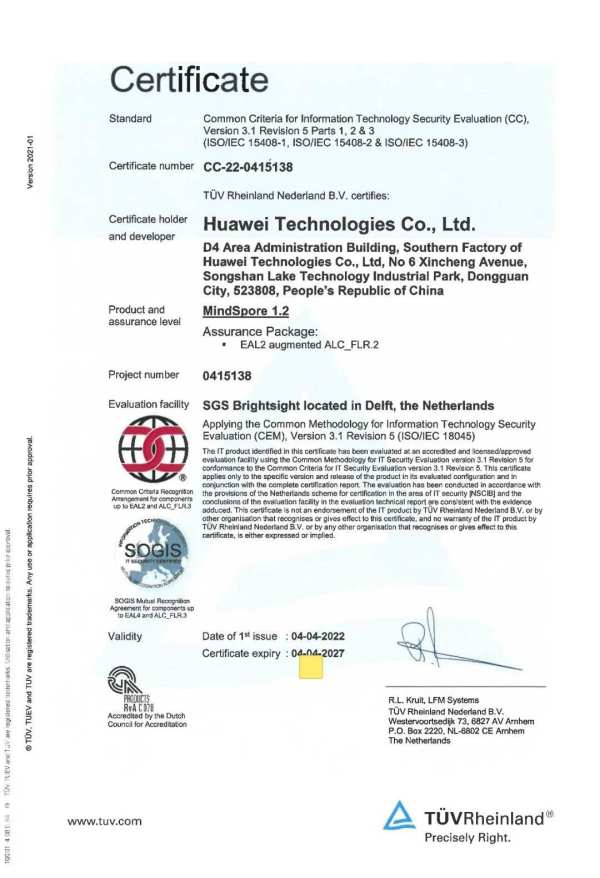

近日,昇思MindSpore正式通过SGS Brightsight实验室的安全评估,获得了AI框架领域的首份CC EAL2+证书。

作为全球最大的独立认证机构,SGS Brightsight可以说是全球为数不多被广泛认可的安全实验室。同时CC认证也是目前全球认可度和权威性最高的IT产品安全认证,主要用于评估产品的安全性、可靠性以及对信息隐私的保护。

在过去很长一段时间里,AI框架和CC认证很少被同时提及,其中的原因离不开AI框架的开源属性,加上人工智能的产业应用才刚刚起步,业界的焦点常常是准确性和易用性,安全性的课题被选择性忽略。可为何昇思MindSpore主动送测SGS Brightsight实验室,并深度参与了人工智能框架安全目标的制定?

隐藏在首份CC EAL2+证书背后的,其实是人工智能的新潮向。

01 AI框架的险滩和暗礁

经历了Theano、Caffe等早期框架的探路,TensorFlow和PyTorch在全球范围内的风靡,再到飞桨、昇思MindSpore等国产框架的崛起,AI框架在第三次人工智能浪潮中扮演的角色早已深入人心。

比如“操作系统”的比喻,AI框架在技术体系中有着承上启下的作用,向下调用底层的计算资源,向上承接算法模型的搭建,开发者无需关注底层的逻辑和细节,可以直接在框架下构建或调用算法模型并进行训练部署,极大地提高了开发效率。

如果说AI框架撬动了人工智能产业化的“大航海”,看似平静的水面下却有着不可小觑的安全盲点。

一种是容易被察觉的“险滩”,典型的例子就是框架及其模型库中的安全漏洞。根据开源软件社区GitHub公布的数据,TensorFlow自2020年以来被曝出的安全漏洞已经有百余个;国内的360团队曾对市场上的主流AI框架进行安全性评测,发现了150多个漏洞;腾讯安全团队公开了TensorFlow组件中存在的重大漏洞,如果开发者编写机器人程序时使用了该组件,黑客可通过漏洞控制机器人……

另一种是难以洞察的“暗礁”,譬如普遍存在的算法黑箱、数据泄露等问题。由于算法模型和复杂性和不确定性,人们无法直观解释结果背后的原因,一旦训练数据中存在偏见,可能会直接影响训练结果。甚至有一些开发者利用算法模型的复杂性,人为植入了一些隐蔽的“后门”,可以在近乎无感的情况下进行攻击,或是窃取开发者上传的敏感数据,或是利用对抗样本等方式干扰模型的判断结果。

当人工智能的应用进入到深水区,落地场景逐渐呈现出指数级增长的态势,对应的安全风险也将被指数级放大。特别是AI框架已经被越来越多企业和开发者依赖,倘若不能扎紧安全口袋,代价可能是雪崩级的灾难。

传统的安全保障像是塔防游戏,黑客寻找攻击的缺口,开发者则努力堵住每一个漏洞,但在人工智能的语境里,假如黑客选择AI框架或者算法模型为攻击点,相当于在城内“空投”了一个个木马,直接破防层层安全机制,以一种悄无声息的方式进行系统级攻击,产生无法估量的损失。

这大抵就是昇思MindSpore深耕安全的原因,人工智能产业想要行稳致远,势必要在源头上消除任何可能的安全风险。

02 昇思MindSpore的解法

某种程度上说,人工智能的安全焦虑并不是什么新话题。早在2017年就出现了可信人工智能的概念,2020年相关论文的研究数量已经有上千篇,一些科技大厂也推出了验证算法模型安全性的工具包。

可大多数讨论仅仅局限在“讨论”的范畴,缺少系统性的方法指引,也未能形成约束性的落地机制。个别公司或开发者开源的工具包,多半是“打补丁式”的解决思路,所能解决的问题比较单一,缺少体系化的方法论和行之有效的策略。

深谙其中症结的昇思MindSpore团队,俨然意识到了AI框架的特殊性,进而围绕AI生命周期构建了一系列的技术能力:

针对算法模型的潜在风险,昇思MindSpore引入了鲁棒性评测、对抗测评、对抗训练、模型加密等技术,帮助客户提升模型的安全性。

比如一些自研或者开源的第三方模型缺少鲁棒性评测,昇思MindSpore给出了基于黑白盒对抗样本、自然扰动等技术的评测方案,帮助客户识别模型的脆弱点,并通过对抗样本检测、数据增强训练等提升鲁棒性;再比如为了防止模型在部署时被窃取,昇思MindSpore提供了模型混淆和元数据加密的轻量级方案,保障模型安全的同时在效率上比全量加密有着10+倍的提升。

针对数据泄露的行业顽疾,昇思MindSpore构建了隐私评估、差分隐私训练、联邦学习在内的数据隐私保障机制。

以争议性最大的个人隐私保护为例,区别于上云集中式训练的做法,昇思MindSpore基于安全多方计算、差分隐私等技术,解决了联邦学习中的隐私泄露问题。同时考虑到一些图像数据中存在涉及用户隐私的敏感数据,昇思MindSpore集成了隐私内容检测、隐私知识构建、隐私消除等一整套能力,可以自动对敏感信息进行消除、填充、替换等处理,确保用户隐私不被泄露。

针对AI可解释性的质疑,昇思MindSpore的答案是通过原创语义级可解释技术、可解释方法工具集等对症下药。

这也是人工智能频频被挑战的诱因所在,毕竟现阶段模型训练的过程往往不可见、模型推理的结果难以解释,再加上数据分布不均匀、多样性不足等问题,导致模型的决策结果可能出现偏差或倾向性。昇思MindSpore正在通过数据清洗、模型容错性评估、提供模型决策的解释等提升数据的公平性、模型的可解释性,继而让用户更理解、信任并有效地使用模型。

也就是说,相较于从伦理层面呼吁人工智能的道德准则,昇思MindSpore已经在框架层面打造了覆盖模型训练、评估、部署的全流程安全可信,为企业和行业提供了源头可信的系统性方案。

03 推开可信AI的大门

有理由相信,SGS Brightsight实验室对昇思MindSpore进行安全评估时,除了框架本身的安全性,昇思MindSpore在模型安全、隐私保护、可解释性方面的工作,同样在评估标准中占了相当大的比重。

站在行业的立场上,全球首份人工智能框架的CC EAL2+证书,所承载的价值不单单是填补了市场空白,还为人工智能框架的安全可信提供了重要参照与标准,有望为整个人工智能产业的可信化进程按下加速键。

即使从2015年AlphaGo和李世石的围棋大战算起,人工智能的产业化也不过才七个年头,可一场信任危机却在蔓延中。

无论是特斯拉等多次上演的自动驾驶事故、部分电商平台的大数据杀熟现象、资讯平台算法推荐的内容同质化风波,还是“外卖小哥困在系统里”的现象级报道、围绕个性化推荐权利的社会性讨论,都预示着公众对于人工智能的态度正在从乐观好奇趋于谨慎质疑,不无制约人工智能产业化渗透的可能。

就昇思MindSpore在安全方面的努力来看,人工智能的信任危机并非无可挽回。直接的例子就是算法推荐,在外界对算法偏见问题群情激奋时,某银行在昇思MindSpore上巧妙规避了潜在风险,通过基于LIME的推荐解释解决了有无解释的问题,利用基于KG的原创可解释推荐网络TB-Net获得了语义级解释能力,既解决了理财推荐结果难解释的困局,又提升了推荐效率和转化成功率。

值得一提的是,不只是SGS Brightsight实验室的CC认证,昇思MindSpore还通过了云计算开源产业联盟的评估,融合国内首批《可信开源社区评估体系》认证,并且支撑华为云的OCR服务通过了独立机构BSI的AI C4审计认证……可信人工智能正在逐步成为整个行业的理性共识。

再来思考昇思MindSpore获得全球首个CC EAL2+证书的时代意义,正在从根源上制约人工智能应用的弊端,为企业打通了强化隐私保护、稳定性、可解释性、公平性的路径,有力地推开了可信AI的大门。