对于新上线的站点快速通过考核期,需要解决搜索引擎识别及信任度的问题,如果这些问题没有妥善的解决,关键词排名要想进入前二十名也难。如果你的网站SEO优化长期没有效果,或出现不收录、排名下降、降权等问题,也可能是这些基础的问题处理不当所致。简小白带大家来来看看搜索引擎对网站的识别和信任度问题。

一、从搜索引擎识别,建立信任度

1、识别路径,给搜索引擎非常顺畅的路径,来抓取你网站的内容。 包括做路径(url)的规范化处理,给予搜索引擎唯一的抓取路径;以及对路径(url)的结构进行合理设置和布局,路径设置越短越好,使搜索引擎非常顺利的抓取和识别网站内容的主次。

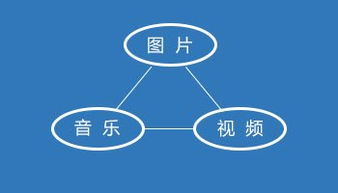

2、识别代码,代码结构要非常清晰 。首先网站代码结构层级要非常清楚明白,多余的代码要清理掉。其次搜索引擎不能识别的代码尽量少放或不放,包含flash js ifarme 图片视频 音频 多层嵌套表格table等。简小白建议table嵌套不要超过两层。

3、识别标签,做好权重代码的设置,让搜索引擎顺利进行加权。包含H标签的应用、alt标签的应用、title标签的设置、加粗标签等。

二、从网站程序内容处理,建立信任度

1、内链 。在网站上线前填充内容时,就应该做好内部文章互相推荐,通过内链系统提升内页权重。另外要避免#号空链接出现在页面中,我们有很多的网站都存在这个问题,还有要用nofollow屏蔽无关的链出,集中网站权重避免权重流失。

2、地图。 让搜索引擎蜘蛛直达页面,网站内容没有完善的时候,不需要做网站地图。如人才网、分类信息、B2B、门户等这些网站,网站架构做的很大内容完善起来难,导致前期会出现很多的空页面。这些空页面一放出来被搜索引擎抓取了,就会导致网站初期评判的整体信用度降低,导致网站获取不到好的排名,甚至很长一段时间都在20名之后徘徊。

3、robots.txt文件。 利用这个文件屏蔽搜索引擎不能识别的和不能让搜索引擎识别的内容。比如前期为了避免把搜索引擎蜘蛛引到空页面,简小白的方法是利用robots.txt文件对空页面进行屏蔽,等内容填充了起来,再取消屏蔽辅以适当外链引入蜘蛛抓取。

4、网站上线前期忌修改内容。如果在网站上线之后修改代码、核心词、版面、路径,一旦处理不好很有可能导致网站信任度出现问题。很多网站为了避免网站内容不完善而出现信任度问题,放肆填充重复的价值含量低的内容,这样是不可取的往往适得其反。我们的内容来源可以到相关网站摘抄,但要注意内容附加值的增加,特别是小站。

三、利用网站优化手段,快速获取排名

如果想更加快速的获取到好的排名,做用户所需求的差异性内容是不错的方法,采取一些差异性的手段也是可取的。比如我们可以利用关键词和内容相关的文章,进行301重定向到新站进行权重和用户的转移。 再比如我们可以利用大规模的资源群,对新站进行权重和用户的导入。

从网站内部内容的差异性而言,我们可以做不一样的标题,包含别人不能做的需求,更新不一样的内容,更新别人不愿意更新但用户需要的内容。 如果我们的网站抓住了更好的用户需求点,就能获得稳定的点击而快速提升排名。

在网站上线初期搜索引擎没有足够的数据评价网站的好坏,就只能根据网站的基础设置给予一个基础权重和初期的排名。因此网站给搜索引擎的第一印象是非常重要的,而后期有效的优化手段更是锦上添花的良助。