量子位 报道 | 公众号 QbitAI

“扫地僧”如何看待2020科技趋势?

刚刚,阿里达摩院2020十大科技趋势发布,涵盖人工智能、芯片制造、量子计算、工业互联网、机器协作、区块链、隐私保护、云计算等多个领域,勾勒新一年科技走向。

快速概览如下:

1、人工智能从感知智能向认知智能演进

2、计算存储一体化突破AI算力瓶颈

3、工业互联网的超融合

4、机器间大规模协作成为可能

5、模块化降低芯片设计门槛

6、规模化生产级区块链应用将走入大众

7、量子计算进入攻坚期

8、新材料推动半导体器件革新

9、保护数据隐私的AI技术将加速落地

10、云成为IT技术创新的中心

达摩院去年预测,过去以CPU为核心的通用计算,将走向由应用驱动和技术驱动,并带来Domain-specific体系结构的颠覆性改变。

过去一年,在应用驱动和技术驱动下,AI专用芯片获得了长足的发展。在具体的场景中,使用专用的芯片将会带来更好的算力和能效,已经成为行业共识。

国内的平头哥、华为、百度、依图、寒武纪等企业都发布了各自的AI专用芯片,国际芯片巨头如英特尔等,也正积极布局AI芯片领域。

在新的一年,达摩院也给出了新的行业发展动向:模块化降低芯片设计门槛。

他们认为,高科技产业中护城河最深、壁垒最厚的领域——造芯,要简单起来了。

这一断言放出,瞬间便引起关注与热议。让人兴奋之余,也有不少人保持冷静思考,这怕不是放卫星上天?

阿里平头哥副总裁孟建熠博士表示,这背后的种种逻辑,在阿里平头哥的实践探索中,逐步清晰明了。

“在新的模块化方法下,各个模块已经提前完成流片,具体到场景中,可以根据需求将不同功能‘芯片模块’通过先进封装,可以跳过流片,通过封装快速定制出一个符合应用需求的芯片,”孟建熠说。

这种新的模块,也有一个代名词:芯粒(Chiplet)。

具体来说,是通过对复杂功能进行分解,开发出多种具有单一特定功能的“芯粒”,如实现数据存储、计算、信号处理、数据流管理等功能。

然后利用这些不同功能的芯粒进行模块化组装,将不同的计算机元件集成在一块硅片上,来实现更小更紧凑的计算机系统结构。

未来计算机的系统结构,可能不是由单独封装的芯片制造的,而是在一块较大的硅片上互连成芯片网络的芯粒制造的。

孟建熠说,模块化的芯片技术,最终可以实现像搭积木一样”组装“芯片,芯片设计的难度至少降低50%。

“尤其是AIoT领域对成本较为敏感,需要新的芯片设计方法,”孟建熠说。

与此同时,市场竞争格局也开始发生变化。在应用驱动的趋势下,谁能快速推出专用芯片,就能抢占市场先机。

阿里达摩院认为,芯片行业传统的比投资、比品牌、比工艺的“大鱼吃小鱼”格局,正逐渐被比市场灵敏度、比需求适配、比速度和价格的“快鱼吃慢鱼”格局所取代。

需求客观存在,解决方案已经明了,进一步实现落地,技术是桥梁。

近年来,以RISC-V为代表的开放指令集及其相应的开源SoC芯片设计、以集成电路块(Chisel)为代表的高级抽象硬件描述语言,以及基于IP的模块化的芯片设计方法等等,共同推动了芯片敏捷设计方法与开源芯片生态的快速发展,越来越多芯片企业开始尝试开源硬件架构进行设计。

清华大学长聘教授尹首一也进一步评论称:“尤其是未来随着异质集成、三维集成等技术的成熟,摩尔定律将在全新维度上得以延续。”

面向2020年,基于芯粒的模块化设计方法正在成为新的行业趋势。孟建熠说,这也是平头哥正在实践探索的方向。

2019年8月30日,阿里平头哥发布AIoT芯片平台,命名“无剑”。

这是一个芯片设计平台,提供集芯片架构、基础软件、算法与开发工具于一体的整体解决方案,是在提升芯片设计效率上的重要一步。

取独孤求败“无剑胜有剑”之意。与此对应,其并无芯片,但可帮助各路芯片设计企业“铸剑”,即在基础框架/模板基础上,定制符合应用需求的芯片产品,以最快速度推向精准市场。

人工智能已经在“听、说、看”等感知智能领域已经达到或超越了人类水准,但在需要外部知识、逻辑推理或者领域迁移的认知智能领域还处于初级阶段。

认知智能将从认知心理学、脑科学及人类社会历史中汲取灵感,并结合跨领域知识图谱、因果推理、持续学习等技术,建立稳定获取和表达知识的有效机制,让知识能够被机器理解和运用,实现从感知智能到认知智能的关键突破。

趋势二、计算存储一体化突破AI算力瓶颈

冯诺伊曼架构的存储和计算分离,已经不适合数据驱动的人工智能应用需求。频繁的数据搬运导致的算力瓶颈以及功耗瓶颈已经成为对更先进算法探索的限制因素。

类似于脑神经结构的存内计算架构将数据存储单元和计算单元融合为一体,能显著减少数据搬运,极大提高计算并行度和能效。计算存储一体化在硬件架构方面的革新,将突破AI算力瓶颈。

趋势五、模块化降低芯片设计门槛

传统芯片设计模式无法高效应对快速迭代、定制化与碎片化的芯片需求。以RISC-V为代表的开放指令集及其相应的开源SoC芯片设计、高级抽象硬件描述语言和基于IP的模板化芯片设计方法,推动了芯片敏捷设计方法与开源芯片生态的快速发展。

此外,基于芯粒(chiplet)的模块化设计方法用先进封装的方式将不同功能“芯片模块”封装在一起,可以跳过流片快速定制出一个符合应用需求的芯片,进一步加快了芯片的交付。

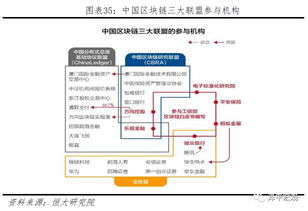

趋势六、规模化生产级区块链应用将走入大众

区块链BaaS服务将进一步降低企业应用区块链技术的门槛,专为区块链设计的端、云、链各类固化核心算法的硬件芯片等也将应运而生,实现物理世界资产与链上资产的锚定,进一步拓展价值互联网的边界、实现万链互联。

未来将涌现大批创新区块链应用场景以及跨行业、跨生态的多维协作,日活千万以上的规模化生产级区块链应用将会走入大众。

趋势九、保护数据隐私的AI技术将加速落地

数据流通所产生的合规成本越来越高。使用AI技术保护数据隐私正在成为新的技术热点,其能够在保证各方数据安全和隐私的同时,联合使用方实现特定计算,解决数据孤岛以及数据共享可信程度低的问题,实现数据的价值。

趋势十、云成为IT技术创新的中心

随着云技术的深入发展,云已经远远超过IT基础设施的范畴,渐渐演变成所有IT技术创新的中心。

云已经贯穿新型芯片、新型数据库、自驱动自适应的网络、大数据、AI、物联网、区块链、量子计算整个IT技术链路,同时又衍生了无服务器计算、云原生软件架构、软硬一体化设计、智能自动化运维等全新的技术模式,云正在重新定义IT的一切。

广义的云,正在源源不断地将新的IT技术变成触手可及的服务,成为整个数字经济的基础设施。

最后,小小互动一下。

你怎么看达摩院关于芯片的预测?达摩院今年发布的十大预测,你更看好哪一个?对于今年科技走向,你有什么预测?

欢迎在评论区留言互动~

—完—

@量子位 · 追踪AI技术和产品新动态

深有感触的朋友,欢迎赞同、关注、分享三连վ'ᴗ' ի ❤